Ein Beitrag von Katharina Schneider (Erklärhelden)

Es ist noch gar nicht lange her, da war das Schlimmste, was einem im Internet begegnen konnte, ein schlecht gephotoshopptes Bild eines Prominenten. Heute scrollt man durch Social Media und sieht den Papst im weißen Daunenmantel rappen oder hört in WhatsApp-Sprachnachrichten Stimmen von Bekannten, die Dinge sagen, die sie nie ausgesprochen haben.

Die Künstliche Intelligenz hat längst Einzug in die Kinderzimmer gehalten. Für Eltern stellt sich so eine ganz neue, dringende Frage: Wie unterscheidet man in der Flut der digitalen Inhalte noch zwischen Realität und Fiktion? Und noch wichtiger: Wie bringt man dem Nachwuchs bei, nicht auf jeden Fake hereinzufallen?

Dieser Artikel beleuchtet die aktuellen KI-Trends auf den beliebten Plattformen und liefert einen Leitfaden, wie Familien digitale Manipulationen entlarven.

Die neue Realität im Feed: Wenn der Schein trügt

Früher hieß es: „Ich glaube nur, was ich sehe.“ Dieser Satz hat im Zeitalter generativer KI seine Gültigkeit verloren. Auf Plattformen wie TikTok, Instagram und YouTube Shorts sind KI-generierte Inhalte keine Ausnahme mehr, sondern fast schon die Regel.

Dabei muss man zwei Kategorien unterscheiden:

- Spaß und Kreativität: Filter, die das Gesicht verändern oder KI-Tools, die aus einem Textbefehl ein lustiges Bild erstellen. Das ist oft harmlos und Teil der Netzkultur.

- Desinformation und Betrug: Deepfakes (täuschend echt wirkende Videos), Voice-Cloning (Stimmenimitation) und gezielte Fake-News.

Besonders für Kinder und Jugendliche verschwimmen diese Grenzen. Wenn ein scheinbar echtes Video auf TikTok behauptet, ein bekannter YouTuber habe eine Straftat begangen oder eine Politikerin habe etwas Absurdes gefordert, wird dies oft ungeprüft geglaubt und weiterverbreitet.

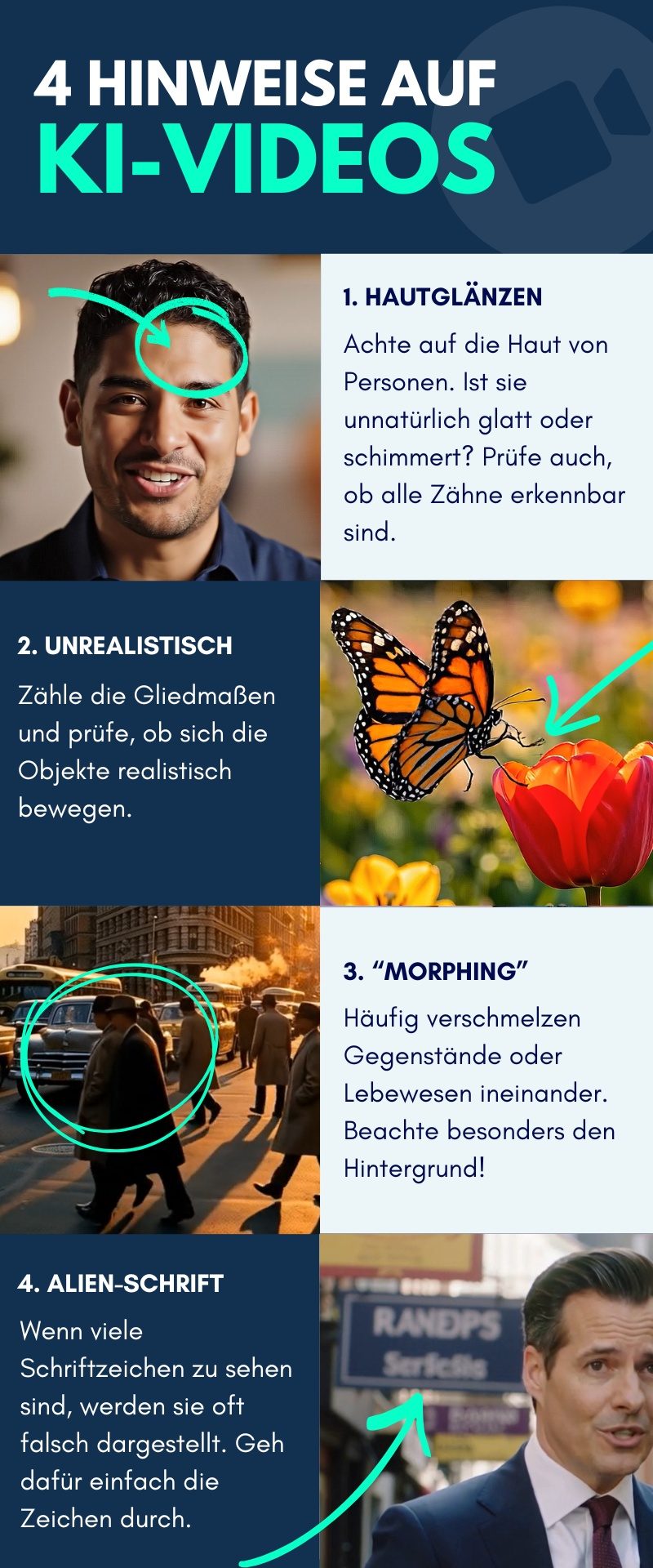

KI-Videos erkennen: Der Teufel steckt im Detail

Die Zeiten, in denen KI-Fakes an einem starren, nicht blinzelnden Blick sofort erkennbar waren, sind vorbei. Moderne Algorithmen haben gelernt zu blinzeln. Wer heute einen hochwertigen Deepfake entlarven will, muss daher Detektivarbeit leisten und auf subtile Fehler achten.

Am besten schaut man solche Videos gemeinsam auf einem größeren Bildschirm an und achtet besonders auf folgende Details:

1. Die Physik des Lichts stimmt nicht

Die KI berechnet Gesichter oft unabhängig von der Umgebung, was zu Beleuchtungsfehlern führt.

- Schattenwurf: Ein kritischer Blick gilt dem Schatten: Passt dieser an Nase oder Hals wirklich zur Lichtquelle im Video (z.B. Sonne oder Lampe)? Oft wirkt das eingefügte Gesicht seltsam „flach“ oder im Vergleich zum Rest des Körpers zu gleichmäßig ausgeleuchtet.

- Reflexionen: Auch die Augen liefern Hinweise. Reflexionen von Lichtquellen in den Pupillen müssen in beiden Augen identisch sein – ein Detail, das die KI häufig vergisst.

2. Der Blick in den Mund verrät viel

Das Innere des menschlichen Mundes ist für eine KI extrem komplex zu berechnen. Zähne, Zunge und der dunkle Rachenraum sind oft die größten Schwachstellen.

- Die Zähne: Diese wirken beim Sprechen oft wie eine undifferenzierte weiße Masse statt wie einzelne Objekte. Gelegentlich generiert die KI auch anatomisch unmöglich viele Zähne im Unterkiefer.

- Die Zunge: Zudem ist auf die Zungenbewegung beim Formen von Lauten wie „L“ oder „T“ zu achten. In vielen Fakes fehlt diese komplett oder wirkt mechanisch.

3. Die „Traum-Logik“ von Bewegungen

In KI-Videos bewegen sich Objekte oft unlogisch, ähnlich wie im Traum.

- Morphing: Hintergrunddetails verraten oft die Manipulation. So verwandeln sich Gegenstände bei Kameraschwenks oder Muster auf der Kleidung ändern sich während der Bewegung.

- Gehen vs. Gleiten: Menschen oder Tiere scheinen in KI-Videos oft über den Boden zu „gleiten“, statt realistische Schritte zu setzen. Füße berühren den Boden teilweise gar nicht oder versinken darin.

In diesem Beispiel lassen sich rechts oberhalb des Hinterrads physikalisch unlogische Bewegungen in der Spiegelung beobachten:

4. Anatomische Unmöglichkeiten bei Tieren und Statisten

Während die Hauptfigur im Video oft gut aussieht, schleichen sich im Hintergrund Fehler ein.

- Gliedmaßen-Lotto: Ein Nachzählen von Beinen und Pfoten schafft oft Klarheit. KI-Hunde haben beim Rennen nicht selten fünf Beine oder Gliedmaßen verschwinden und tauchen wieder auf.

- Hände: Auch in Videos ohne Fokus auf Gesichter bleiben Hände verräterisch. Oft verschmelzen sie mit gehaltenen Objekten, wie etwa Kaffeetassen.

Sind das bei diesem Schmetterling nun zwei oder doch drei Flügel? Die KI konnte sich nicht entscheiden:

5. Alien-Schrift und sinnlose Architektur

KIs können zwar Bilder von Straßenschildern oder Buchcovern erzeugen, aber bei großen Textmengen schleichen sich auch mal Darstellungsfehler ein.

- Gibberish: Schriftzüge auf Werbeplakaten oder Straßenschildern im Hintergrund könnten unleserlich sein und erinnern an eine fremdartige „Alien-Schrift“ oder verschwommene Hieroglyphen.

- Architektur: Treppen, die im Nichts enden, oder Fenster, die schief in der Wand hängen, sind typische Zeichen für KI-Generierung.

Die Schilder im Hintergrund von KI-Bildern lassen sich nicht immer korrekt identifizieren. Hier in diesem Video sind alle hilfreichen Checks nochmal zusammengefasst:

Für Eltern ist es ratsam, sich auf etablierten Medienkompetenz-Portalen zu informieren. Die Initiative klicksafe bietet beispielsweise umfangreiche Materialien und aktuelle Warnhinweise zu Deepfakes, die man als Familie durchgehen kann.

Der „Enkeltrick 2.0“: Gefahr durch Voice-Cloning bei WhatsApp

Während KI-Videos auf TikTok meist der Unterhaltung oder politischen Stimmungsmache dienen, lauert in Messengern wie WhatsApp eine unmittelbare Gefahr. Betrüger nutzen mittlerweile KI, um Stimmen zu klonen. Dafür reichen oft wenige Sekunden Audiomaterial, das man beispielsweise aus einem öffentlichen Instagram-Video oder einer TikTok-Story extrahieren kann.

Das Szenario: Eltern oder Großeltern erhalten eine Sprachnachricht oder einen Anruf. Die Stimme klingt exakt wie die des Sohnes oder der Tochter. Der Inhalt ist dramatisch: ein Unfall, Geldnot, das Handy sei kaputt.

Hier hilft technische Analyse nur bedingt, da die Qualität oft durch die schlechte Telefonverbindung oder Kompression kaschiert wird. Der beste Schutz ist hier ein analoges Passwort. Familien sollten ein Sicherheitswort vereinbaren, das im Notfall abgefragt werden kann. Kann der Anrufer das Wort nicht nennen, legt man auf. Zudem empfiehlt die polizeiliche Kriminalprävention dringend, niemals auf Geldforderungen einzugehen, die per WhatsApp gestellt werden, ohne die Person unter der alten, bekannten Nummer gegenzuchecken.

Im Zweifel einfach selbst die Person zurückrufen und so sichergehen, dass es sich wirklich um das Familienmitglied handelt.

Schönheitsideale aus dem Rechner: Die psychologische Komponente

Neben den offensichtlichen Fakes gibt es eine subtilere Form der Manipulation: „Bold Glamour“ und andere KI-gestützte Beauty-Filter. Anders als die alten Snapchat-Filter, die bloß Hasenohren aufsetzten, verändern moderne Filter die Gesichtsstruktur in Echtzeit. Sie machen die Nase schmaler, die Lippen voller und die Haut makellos – und zwar so stabil, dass der Filter auch bleibt, wenn man sich mit der Hand durchs Gesicht fährt.

Das vermittelt Kindern, insbesondere Teenagern, ein völlig verzerrtes Realitätsbild. Wenn Väter beobachten, dass der Nachwuchs Fotos nur noch stark bearbeitet postet, ist ein Gespräch fällig. Gleiches gilt auch für den reinen Konsum dieser Bilder. Es geht nicht um Verbote, sondern um das Bewusstsein: „Das, was du da siehst, ist eine mathematische Berechnung, kein menschliches Gesicht.“

Expertentipp: Verstehen statt Verbieten

Wie geht man also im Familienalltag damit um? Ein Totalverbot ist selten zielführend, da es die Nutzung eher in heimliche Kanäle verlagert. Viel wichtiger ist die Begleitung.

Wer Bewegtbilder noch professionell von Hand gestaltet, sieht die Dinge anders. Katharina Schneider von der Berliner Erklärvideo-Agentur Erklärhelden hat beruflich jeden Tag mit der Produktion und Recherche von animierten Videos zu tun. Sie kennt daher die technischen Kniffe und rät Eltern zu einem proaktiven Ansatz:

„Medienkompetenz beginnt nicht mit dem Zeigefinger, sondern mit Neugier. Wenn Eltern gemeinsam mit ihren Kindern spielerisch testen, wie KI funktioniert, etwa indem sie zusammen ein KI-Bild generieren und nach Fehlern suchen, verliert die Technik ihren mystischen Schleier. Kinder, die verstehen, wie ein Bild manipuliert wird, lassen sich später viel schwerer täuschen.“

Dieses gemeinsame Entdecken stärkt nicht nur die Kompetenz der Kinder, sondern auch das Vertrauen zu den Eltern als Ansprechpartner bei digitalen Problemen.

Checkliste für den Alltag: Fake oder Fakt?

Um die Medienkompetenz zu Hause zu stärken, kann man sich an dieser kurzen Checkliste orientieren, wenn einem ein Inhalt irreal vorkommt:

- Quelle prüfen: Wer hat das gepostet? Ein verifizierter Account oder ein Profil ohne Follower und Impressum?

- Reverse Image Search: Bei spektakulären Bildern hilft oft die Google-Bildersuche. Taucht das Bild im Kontext seriöser Nachrichten auf oder wird es dort bereits als Fake entlarvt?

- Emotionen hinterfragen: Zielt das Video darauf ab, extreme Wut, Angst oder Mitleid auszulösen? KI-Inhalte werden oft so gestaltet, dass sie emotionale Kurzschlüsse erzeugen, damit man sie teilt, ohne nachzudenken.

- Gliedmaßen prüfen: KI-Bildgeneratoren haben (noch) oft Probleme mit Arm- und Beinbewegungen. Zu viele Finger, ineinander laufende Beine oder anatomisch unmögliche Gelenke sind ein sicheres Zeichen für KI.

Fazit: Väter als digitale Mentoren

Die technologische Entwicklung lässt sich nicht zurückdrehen. KI wird ein fester Bestandteil unseres Alltags bleiben und noch leistungsfähiger werden. Das muss kein Grund zur Panik sein. Im Gegenteil: Für Väter bietet sich hier die Chance, die Rolle des digitalen Mentors zu übernehmen.

Wer sich selbst fit hält, die neuen Tools nicht verteufelt, sondern ausprobiert und die Mechanismen dahinter versteht, kann seine Kinder sicher durch den digitalen Dschungel begleiten. Ein gesundes Maß an Skepsis, kombiniert mit offenem Dialog am Abendbrottisch, ist der beste Virenscanner, den man seiner Familie installieren kann. So werden aus konsumierenden Kids kompetente User, die dem Algorithmus nicht hilflos ausgeliefert sind.

———————————————–

Zur Autorin

Katharina Schneider kommuniziert für die Erklärhelden aus Berlin und kreiert jeden Tag als Konzepterin Erklärvideos für Unternehmen aus der gesamten DACH-Region. Als kreativer Teil der Erklärvideo-Agentur hilft sie so bei über 300 Projekten jedes Jahr, dass Kunden innerhalb von 90 Sekunden verstanden werden und so langweilige Textwände auf Webseiten und Marketingunterlagen ersetzt werden.